Le consortium Unicode a annoncé la sortie de la version 16.0.0 de sa norme d’encodage des caractères le 10 septembre 2024. En bref, cette version voit le nombre de caractères passer de 149 813 à 154 998, soit 5 185 caractères supplémentaires. Elle ajoute sept nouvelles écritures, de nouveaux fichiers de données et quatre normes techniques Unicode sont versionnées pour être synchrones avec la norme Unicode. Elle remplace toutes les autres versions, la précédente datant de 2022.

Quelques-uns de ces changements sont détaillés ci-après, et, évidemment, tout figure dans les notes de version (en).

Sommaire

- Afrique

- Asie

- Albanie

- Émoji et héritage informatique

- Synchronisation

- Montée en version vers Unicode 16

- Fin

Afrique

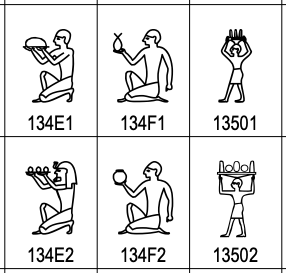

Les hiéroglyphes égyptiens, le principal ajout en nombre de caractères

On se souvient peut-être des réactions des égyptologues, lors de l’introduction des hiéroglyphes égyptiens dans le standard Unicode en 2009. Il ne contenait que les sept-cent signes de base répertoriés par l’égyptologue britannique Alan H. Gardiner (1879 – 1963). Le gros reproche était le faible nombre de hiéroglyphes retenus : on en connaît plus de 6 000. Unicode 16 a rajouté 3 995 caractères aux 1 654 existants déjà dans le standard. Ce qui porte à 5 649 le nombre de hiéroglyphes égyptiens du catalogue Unicode

Les hiéroglyphes égyptiens occupent les blocs Unicode 13460 à 1355F.

L’alphabet Garay

L’alphabet Garay fait son entrée dans les blocs Unicode 10D40 à 10D8F.

Cet alphabet a été créé en 1961 par El Hadji Assane Faye, qui fut, entre autres, président du mouvement des enseignants en langues africaines. L’objectif étant de retranscrire « les caractéristiques sociolinguistiques africaines ». L’alphabet Garay comporte vingt-cinq consonnes et quatorze voyelles. Il est notamment utilisé pour le wolof, langue nationale du Sénégal, de la Mauritanie et de la Gambie. Il s’écrit de droite à gauche.

Asie

Les écritures de langues indiennes

Cinq écritures sont ajoutées à cette version d’Unicode. Les quatre premiers alphabets sont récents :

- Gurung Khema ou Khema est l’une des écritures utilisées pour retranscrire le Gurung (en), une langue parlée dans le Népal, il s’écrit de gauche à droite et occupe les blocs Unicode 16100 à 1613F,

- Kirat Rai (en), qui s’écrit de gauche à droite, est utilisé pour écrire le Bantawa, une langue parlée dans l’est de l’Himalaya et l’est du Népal, les blocs Unicode 16D40 à 16D7F lui sont réservés,

- Ol Onal a été inventé entre 1981 et 1992 (en) par Mahendra Nath Sardar pour transcrire la langue Bhumij, une langue parlée par quelques populations de l’ouest du Bengale et des états indiens Jharkhand, Odisha et Assam. Elle s’écrit de gauche à droite et on la retrouvera dans les blocs Unicode 1E5D0 à 1E5FF,

- Sunuwar (en), une écriture qui a été développée en 1942 par Krishna Bahadur Jentich (1926 - 1991) pour écrire la langue éponyme parlée dans le Sikkim, un État du nord de l’Inde, et au Népal, s’écrit de gauche à droite et figure dans les blocs Unicode 11BC0 à 11BFF,

- Tulu-Tigalari ou Tilagari est une écriture plus ancienne. L’alphabet a été conçu à partir de l’alphabet Grantha, une écriture du sud de l’Inde, depuis le XIe siècle. Utilisé au départ pour le sanscrit, le Tilagari (en) sera aussi l’écriture du Tulu, une langue du sud-ouest de l’Inde à partir du XVe siècle. Il s’écrit de gauche à droite et occupe les blocs Unicode 11380 à 113FF.

Japon

La base de données des caractères japonais « Moji Jōhō Kiban » (文字情報基盤) a été ajoutée comme source de référence (en) aux 36 000 idéogrammes unifiés CJC (chinois, japonais, coréen). Ce qui se reflète dans les tableaux de codes de pratiquement tous les blocs d’idéogrammes unifiés CJC par des glyphes représentatifs supplémentaires dans la colonne « J ».

Albanie

L’alphabet Todhri (en) a été inventé par Todhri Haxhifilipi (1811 - 1869) pour écrire en langue albanaise. Composée de cinquante-deux caractères, il s’écrit de gauche à droite et semble dériver de l’écriture cursive romaine.

Les blocs Unicode 105C0 à 105FF lui sont réservés.

Émoji et héritage informatique

Sept nouveaux émojis font leur entrée :

- une tête avec des valises sous les yeux (face with bags under eyes), 1FAE9,

- une empreinte digitale (fingerprint), 1FAC6,

- un arbre sans feuille (leafless tree), 1FABE,

- un radis (root végétable), 1FADC,

- une harpe (harp), 1FA89,

- une pelle (shovel), 1FA8F,

- une éclaboussure (splatter), 1FADF.

À cela s’ajoutent sept-cent symboles (en) d’environnements informatiques, blocs Unicode 1CC00 à 1CEBF (Symbols for Legacy Computing Supplement).

Synchronisation

Plusieurs spécifications Unicode importantes ont été mises à jour. Notamment les quatre standards UTS #10, UTS #39, UTS #46, et UTS #51. Ils sont maintenant versionnés de façon synchronisée avec le standard Unicode, leurs fichiers de données couvrant les mêmes répertoires. Ils ont tous été mis à jour en version 16.

| Spécification | Champ d’application | Fichiers de données |

|---|---|---|

| UTS #10, Unicode Collation Algorithm (en) | Tri du texte Unicode | UCA data (en) |

| UTS #39, Unicode Security Mechanisms (en) | Réduction de l’usurpation d’identité en Unicode | Security data (en) |

| UTS #46, Unicode IDNA Compatibility Processing (en) | Traitement des URL non-ASCII URLs | IDNA data (en) et IDNA 2008 derived data (en) |

| UTS #51, Unicode Emoji (en | Émoji et leur comportement | Emoji data (en) |

Ces modifications sont susceptibles de nécessiter des changements dans les implémentations. Les sections migrations et modifications des standards UTS #10 (en), UTS #39, (en), UTS #46 (en) et UTS #51 (en) indiquent comment y procéder.

Montée en version vers Unicode 16

Quels impacts pour cette montée en version, outre les modifications apportées par l’ajout de nouveaux caractères et de nouveaux systèmes d’écriture ? Ils semblent plutôt mineurs, le changement le plus notable concerne sans doute celui de l’accès aux spécifications Unicode :

- les spécifications de base ont été complètement remaniées pour Unicode 16.0 et, converties en HTML, elles sont déployées dans un sous-site autonome,

- plusieurs des caractères ajoutés peuvent avoir quelques implications sur certaines optimisations de la normalisation; cela ne modifie pas l’algorithme de normalisation, mais il peut y avoir des conséquences sur la dérivation et l’utilisation des propriétés Quick_Check pour l’optimisation de la détection des formes de normalisation, voir UAX #15 (en),

- des modifications ont été apportées sur les sauts de lignes apportées au guillemet simple gauche, U+2018

‘et aux guillemets directionnels similaires dans les contextes spécifiques d’Asie de l’Est afin de corriger les sauts de ligne en chinois simplifié et mieux coller aux spécifications au comportement de l’ICU (International Components for Unicode, bibliothèque logicielle, à ne pas confondre avec la fédération internationale des cheerleaders), voir UAX #14 (en), - quelques changements ont été apportés à la spécification afin de mieux s’aligner sur les pratiques courantes et simplifier les éléments transitoires qui ne sont plus nécessaires.

Fin

On laissera le mot de la fin à St00e9phane Bortzmeyer1 au sujet d’un site (de 2023) codé avec les pieds et une faible connaissance d’Unicode :

Si tu n’es pas assez fort pour lire les points de code Unicode, c’est que tu ne t’appliques pas assez de discipline.

J’en profite pour le remercier d’avoir fait passer l’information sur la sortie d’Unicode 16 sur Mastodon, sinon je l’aurais complètement ratée.

-

Stéphane Bortzmeyer consacre le dernier chapitre de son livre Cyberstructure (2018, C&F) à l’Unicode et raconte comment son prénom est maltraité. Ceci est ma petite contribution à sa collection personnelle. ↩

Aller plus loin

- Annonce de la sortie d’Unicode 16.0.0 (72 clics)

- Version 16 d'Unicode (blog de Stéphane Bortzmeyer) (162 clics)

- Notes de version (36 clics)

- Alphabets en danger (50 clics)

# Enfin!

Posté par pulkomandy (site web personnel, Mastodon) . Évalué à 8.

Quelques symboles utiles dans cette catégorie pour les irréductibles du terminal ou des forums usenet.

On va enfin pouvoir faire des schémas électroniques lisibles en "ASCII" art (pardon pour l'abus de langage), puisque ce bloc contient des résistances, diodes, transistors, et autres condensateurs, ainsi que quelques portes logiques.

Nous avons également des douzièmes de cercles (parfait pour une animation de chargement), les personnages du jeu Space Invaders, quatre types de bombes atomiques et un nuage d'explosion en forme de champignon, un entonnoir, des caractères semigraphiques qui découpent un caractère en 6 ou en 8 blocs, sans oublier "OLD PERSONAL COMPUTER WITH MONITOR IN PORTRAIT ORIENTATION" (ancien ordinateur personnel avec un écran en orientation portrait).

Quel est votre préféré?

[^] # Re: Enfin!

Posté par Ysabeau 🧶 (site web personnel, Mastodon) . Évalué à 5.

Je peux bien l'avouer, je ne voyais absolument pas l'intérêt d'ajouter toute cette collection de vieux symboles informatiques (qui ne me parlent absolument pas). Merci d'avoir éclairé ma lanterne sur ce point.

« Tak ne veut pas quʼon pense à lui, il veut quʼon pense », Terry Pratchett, Déraillé.

[^] # Re: Enfin!

Posté par pulkomandy (site web personnel, Mastodon) . Évalué à 8.

Je pense que l'objectif d'Unicode est surtout d'avoir une liste exhaustive de tous les symboles qui existent, afin de pouvoir convertir n'importe quel texte en Unicode.

Donc, peu importe si c'est vraiment utile pour les nouveaux développements.

Si on ne fait pas ça, il y aura toujours quelqu'un pour dire "oui mais en Unicode je ne peux pas dessiner un transistor" et des risques de perte/dégradation de données lorsqu'on convertit quelque chose en Unicode. On est donc, dans certains cas, obligé de stocker l'information d'encodage (est-ce que c'est de l'Unicode, ou autre chose) avec le texte. Le but (ambitieux) d'Unicode étant de régler ce problème une bonne fois pour toutes, ils sont obligés d'inclure le moindre cas particulier du système le plus obscur.

Un "vrai" exemple d'utilisation: je développe un émulateur pour les ordinateurs Amstrad CPC qui est équipé d'un debugger permettant d'analyser la mémoire. Ce debugger permet d'afficher par exemple du texte contenu dans la mémoire de la machine. Il est très pratique de pouvoir convertir ce texte en Unicode pour l'afficher dans mon système moderne sur lequel fonctionne l'émulateur. Pour certains caractères, ce n'est possible que parce que je jeu de caractères spéciaux de l'Amstrad CPC a été fidèlement reproduit dans Unicode. Sinon, je serais obligé de faire cette conversion d'une autre façon (avec une police de caractères personnalisée par exemple), ce qui revient à perpétuer un encodage de texte exotique et non standardisé.

C'est là le vrai rôle de ces blocs "legacy computing" (rétro informatique).

Ce qui n'empêche pas aussi de trouver de nouvelles utilisations pour ces caractères un peu oubliés, et en particulier pour les personnes qui utilisent toujours un terminal en mode texte (pour des raisons de limitations techniques, de vitesse, ou simplement par préférence personnelle). Ils ont tous été ajoutés pour une raison valable dans le contexte d'une autre machine, d'une informatique d'un autre temps peut-être, mais il n'y a pas de raison a priori que les idées explorées alors ne soient plus utilisables aujourd'hui. J'en donnais quelques exemples dans mon premier message, mais il y en a sûrement plein d'autres.

[^] # Re: Enfin!

Posté par lejocelyn (site web personnel) . Évalué à 3.

En théorie, ça devrait être un but perdu d'avance, vu qu'on devrait pouvoir créer de nouveaux caractères quand on en a besoin. Malheureusement, j'ai dû mal à concevoir comment on pourrait permettre aux gens de créer des nouveaux caractères, les intégrer dans leurs documents et transmettre les informations nécessaires pour les afficher dynamiquement.

C'est particulièrement dommageable pour les systèmes pictographiques/idéographiques, mais moi j'aimerais bien pouvoir créer de nouveaux signes de ponctuations, bon avec (La)TeX, je vois comment faire (en les dessinant), mais sinon, c'est un peu compliqué.

[^] # Re: Enfin!

Posté par Ysabeau 🧶 (site web personnel, Mastodon) . Évalué à 2.

Ça pose surtout problème pour les systèmes qui ne sont plus employés comme les hiéroglyphes égyptiens puisqu'il faut le temps que ça soit adopté par Unicode. Et j'ai l'impression que les systèmes idéographiques et autres du même genre ont tendance à se simplifier plutôt que se complexifier.

Quant à la création de nouveaux signes de ponctuation, elle pose deux problèmes : sa nécessité d'abord ensuite sa compréhension. Si c'est pour faire des signes de ponctuation pour soi tout seul, à mon avis, l'intérêt est très limité.

« Tak ne veut pas quʼon pense à lui, il veut quʼon pense », Terry Pratchett, Déraillé.

[^] # Re: Enfin!

Posté par Benoît Sibaud (site web personnel) . Évalué à 4.

Ce n'est pas le but des zones à usage privé ? so that third parties may assign their own characters without conflicting with Unicode Consortium assignments

https://en.wikipedia.org/wiki/Private_Use_Areas#Private_Use_Areas

[^] # Re: Enfin!

Posté par Ysabeau 🧶 (site web personnel, Mastodon) . Évalué à 3.

Si ! Et cela a été utilisé notamment pour les hiéroglyphes égyptiens ou pour des logos.

« Tak ne veut pas quʼon pense à lui, il veut quʼon pense », Terry Pratchett, Déraillé.

[^] # Re: Enfin!

Posté par lejocelyn (site web personnel) . Évalué à 2.

Je ne vois pas trop le rapport avec ce que j'ai écrit, donc j'imagine que mon propos n'était pas trop clair.

Non, le problème concerne principalement les «langues actives», c'est-à-dire avec des locuteur⋅es vivant⋅es. Par exemple, je me souviens de mon prof de chinois qui me racontaient comment l'imprimerie avait eu pour conséquence que les gens étaient moins créatifs niveau caractères, et se limitaient à réutiliser l'existant, plutôt que d'en créer de nouveaux, car c'était devenu trop compliqué.

Ben, la nécessité d'avoir des nouveaux symboles, elle est courante et ancienne, du point d'ironie à la créativité vis-à-vis des émoticones. Quant à la compréhension, ben il suffit de partager l'interprétation quand on sait qu'un signe n'est pas courant.

Après, peut-être que je sur évalue la difficulté à avoir un nouveau caractère au sein de l'Unicode, mais de mon point de vue, ça devrait être quelque chose de dynamique plus qu'institutionnelle. Peut-être qu'en passant par une «bloc-chain», on pourrait se partager dynamiquement une référence pour les chaines de caractères, et les associer à des polices ;)

[^] # Re: Enfin!

Posté par Ysabeau 🧶 (site web personnel, Mastodon) . Évalué à 6.

Pourtant mon propos répondait très directement au tiens. La lourdeur relative de l'ajout de caractère au standard Unicode a été (et est encore je suppose) une difficulté pour ajouter des systèmes d'écriture passés ou avec peu de locuteurs et de locutrices, notamment, mais pas que, parce qu'il faut des gens et des organismes pour porter les projets.

Sinon comme cela a été dit, il reste la zone privée que tu peux utiliser pour tes ajouts et qui est utilisée. J'avais écrit le processus de création d'une police de caractère dans une précédente dépêche avec toutes les sources auxquelles tu pourras te référer. Et c'est plus simple, à mon avis, que ce que tu suggères.

« Tak ne veut pas quʼon pense à lui, il veut quʼon pense », Terry Pratchett, Déraillé.

[^] # Re: Enfin!

Posté par thoasm . Évalué à 4.

C'est vrai qu'à terme, si unicode est utilisé universellement, ça risque d'être difficile de justifier de l'utilisation d'un nouveau symbole si quasi personne ne l'utilise parce qu'il n'est pas dans unicode. Ça rappelle par exemple l'histoire de l'insertion du drapeau breton dans unicode ou il y a eu une expérimentation et des campagnes pour motiver les gens à l'utiliser sur les réseaux sociaux pour démontrer qu'il y avait un besoin https://www.emoji.bzh/ https://www.emoji.bzh/ https://www.bretagne.bzh/presse/communiques-dossiers/emojibzh-a-vos-tweets-pour-soutenir-la-creation-de-lemoji-drapeau-breton/

Ben on a beau voir des drapeaux bretons dans n'importe quelle manifestation publique n'importe ou en france (« il y a toujours un con avec le drapeau breton », c'est même une légende de la chanson française https://www.youtube.com/watch?v=upQMjdj-jz8) … il n'y a toujours pas de drapeau breton dans unicode à ma connaissance.

[^] # Re: Enfin!

Posté par Stéphane Bortzmeyer (site web personnel, Mastodon) . Évalué à 4.

Il n'y a pas de drapeau pour les régions, uniquement pour les pays (plus précisement, uniquement pour les entités qui ont un code ISO 3166). Les Bretons devraient arrêter de se regarder le nombril, la question n'est pas spécifique à la Bretagne.

Au passage, cette règle d'utiliser le code ISO 3166 est également une question technique : les drapeaux nationaux sont encodés en utilisant les codes en question comme point de code (le drapeau n'est pas un seul point de code mais une combinaison).

[^] # Re: Enfin!

Posté par devnewton 🍺 (site web personnel) . Évalué à 8.

Par contre, il y a des emoji pour les elfes. Ils pourraient prétendre un emoji "breton" au titre de créatures fantastiques.

Le post ci-dessus est une grosse connerie, ne le lisez pas sérieusement.

[^] # Re: Enfin!

Posté par BAud (site web personnel) . Évalué à 4. Dernière modification le 30 septembre 2024 à 13:19.

mais il y a des pavillons : https://regarddecorsaire.com/le-pavillon-malouin/ ;-)

et pas mal ont déjà leur unicode : https://www.alt-codes.net/flags dont le drapeau pirate ;-)

[^] # Re: Enfin!

Posté par thoasm . Évalué à 4.

Pour les emoji les systèmes de chat un peu moderne implémentent des systèmes qui vont au delà des emoji unicode, ou qui le précèdent d'ailleurs, par exemple parmi les précurseurs les totoz de hfr https://forum.hardware.fr/hfr/wiki_smilies-totoz.htm qui permettent d'insérer des petites images (avec un petit nom) dans un post de forum. C'est un système réutilisé sur la tribune de linuxfr au travers du site https://totoz.eu/ également, et extensible librement.

La plupart des systèmes de chat modernes "conviviaux" possèdent ce genre de systèmes. Ça permet de la créativité et une certaine extensibilité. C'est par contre à l'inverse plus de l'ordre de la référence entre amis que des trucs bien standardisés, même si certaines références peuvent se répandre. C'est aussi plus proche des langues de "jeunes" que des organisme de standardisation, avec ce que ça peut avoir d'aussi créatif, original ou incongru, memesque, que potentiellement éphémère, ce qui pose sans doute problème pour la standardisation.

Après si preuve d'utilisation d'ampleur il doit y avoir sur plusieurs chats ça devrait pouvoir compter pour les standardisations.

[^] # Re: Enfin!

Posté par devnewton 🍺 (site web personnel) . Évalué à 5.

Une attitude saine!

Unicode c'est la bloat attitude.

Le post ci-dessus est une grosse connerie, ne le lisez pas sérieusement.

[^] # Re: Enfin!

Posté par pulkomandy (site web personnel, Mastodon) . Évalué à 8.

MAIS OUI SUPPRIMONS TOUS LES ACCENTS ET LES SIGNES DE PONCTUATION CA NE SERT A RIEN TOUT CA ET PUIS LES MINUSCULES QUEL GASPILLAGE TOUT UN DEUXIEME ALPHABET POUR FAIRE EXACTEMENT LA MEME CHOSE

[^] # Re: Enfin!

Posté par thoasm . Évalué à 2.

Si on pouvait se débarrasser des lettres muettes aussi, tant qu'à faire dans le minimalisme, je signe.

[^] # Re: Enfin!

Posté par devnewton 🍺 (site web personnel) . Évalué à 3. Dernière modification le 29 septembre 2024 à 12:04.

je sui d acor

Le post ci-dessus est une grosse connerie, ne le lisez pas sérieusement.

[^] # Re: Enfin!

Posté par esdeem . Évalué à 3.

Dans l'idée, je suis plutôt pour, mais mon cerveau est totalement contre.

Il fait des refus d'obstacle à chaque fois.

0. Assume good faith 1. Be kind to other people 2. Express yourself 4. Apply rule 0

[^] # Re: Enfin!

Posté par Pol' uX (site web personnel) . Évalué à 7.

C'est pour ça qu'il est parfois proposé de couper la tête avant de trouver la voie.

Adhérer à l'April, ça vous tente ?

[^] # Re: Enfin!

Posté par Benoît Sibaud (site web personnel) . Évalué à 10.

I. REVENIR A L ALPHABET LATIN LE VRAI

II. IE GRAVE SVR MARBRE POVR MOINS BAVASSER

III. TOVT VNIFIER PAR L IMPERIALISME

IV. SESTERCES!

[^] # Re: Enfin!

Posté par Ysabeau 🧶 (site web personnel, Mastodon) . Évalué à 7.

Ben, justement, il y a deux styles d'écriture romaine, celle en majuscule pour la gravure et la cursive pour tout le reste, plus rapide écrire. Je revendique le droit à l'usage de la cursive latine.

(déjà ça coûtera moins cher en fourniture, pas besoin de marbre)

« Tak ne veut pas quʼon pense à lui, il veut quʼon pense », Terry Pratchett, Déraillé.

[^] # Re: Enfin!

Posté par totof2000 . Évalué à 3. Dernière modification le 22 octobre 2024 à 15:10.

FARPAITMENT !! MACHIN A RAISON !

[^] # Re: Enfin!

Posté par Tonton Th (site web personnel, Mastodon) . Évalué à 4.

https://www.dcode.fr/code-baudot

[^] # Re: Enfin!

Posté par pulkomandy (site web personnel, Mastodon) . Évalué à 4.

Dans le code Baudot il n'y a certes que des majuscules, mais il y a des ponctuations et surtout le É. Pas étonnant puisque l'inventeur se prénomme Émile.

Bien entendu les autres pays adoptant le code se sont empressés oe remplacer ce É par d'autres symboles qui leur semblaient plus utiles, et c'est là que les problèmes ont commencé

[^] # Re: Enfin!

Posté par vpo . Évalué à 8.

Un locuteur, une locutrice, pas une locuteure.

Donc si tu veux écrire avec des points médians, soit, mais pourquoi changer la forme féminine ?

Avec 'rice' pour le féminin c'est même bien plus simple à prononcer puisque on peut écrire en forme inclusive, "locuteurices".

D'ailleurs, auteure est un non-sens grammatical. C'est autrice qui est la forme logique. Cela vient de auctrixe attesté au 16e siècle.

[^] # Re: Enfin!

Posté par lejocelyn (site web personnel) . Évalué à 0. Dernière modification le 03 octobre 2024 à 01:09.

Non, je n'ai pas l'intention de changer la prononciation de locutrice en locuteure (avec la prononciation du sud, on entend le «e»), c'était juste un raccourci symbolique pour signifier le féminin, rien d'autre :) De manière générale, l'utilisation de la ponctuation pour signifier plusieurs genres me semblent plus un procédé symbolique qu'une manière de noter la prononciation voulue du mot. Sinon autant écrire «locuteures», ce n'est pas ambigu puisqu'on a la forme locutrices, donc on comprend bien qu'on a affaire à du multigenre. Ceci étant, je n'ai rien non plus contre la forme locuteurices, en fait, le seul truc qui me dérange, c'est le ton assez autoritaire du commentaire.

[^] # Re: Enfin!

Posté par vpo . Évalué à 3.

Faire passer le ton dans un écrit, c'est toujours compliqué.

C'était un commentaire étonné pas autoritaire.

La grammaire c'est un ensemble de règle et d'habitudes partagées pas les usagers d'une langue.

Et à titre perso, j'estime que les habitudes ça ce change. Comme disait Grévisse, le bon usage d'une langue c'est ce qu'en font ses locuteurs. Et de toute façon ça a toujours été le cas depuis des millénaires, n'en déplaisent aux académicien⋅nes!

A titre perso, je subvocalise dans ma tête quand je lis, donc ce n'est pas pratique du tout à lire le point médian. Mais il faut vivre dans une caverne pour ne pas comprendre en 2024 un texte qui l'utiliserait.

Bref pour reformuler:

Je ne comprenais pas pourquoi ton usage du point médian devait changer la forme féminine de "locuteur". La règle communément admise pour l'usage du point médian étant de mettre la forme féminine du mot juste après sa forme masculine. Sinon, ça fait encore une exception grammaticale à se farcir. Ou alors soyons cohérent, on décide une bonne fois pour toute que tous les féminin de mot en "eur" c'est "eure" et on est tranquille :-)

[^] # Re: Enfin!

Posté par BAud (site web personnel) . Évalué à 3.

et locutrices ! :p (ou est-ce locuteurices ? :D)

j'ai exactement ce même souci, outre que ça « accroche » les yeux et nuit à ma manière de pratiquer la lecture rapide (je suis obligé de revenir sur le mot :/)

oui, mais, non : trop de changements dans les logiciels d'orthographe et de grammaire et dans les dictionnaires :/ quelque part, c'est assumer une « dette technique » ;-)

[^] # Re: Enfin!

Posté par vpo . Évalué à 2.

Objection votre honneur (oui je sais, on ne dit pas ça dans le système pénal français :-)), mais subvocaliser ça existe

[^] # Re: Enfin!

Posté par BAud (site web personnel) . Évalué à 2. Dernière modification le 04 octobre 2024 à 17:23.

bin Maître Capelo le disait :/

ça va être compliqué si on pénalise l'ortografe et la gramère :p — ceux en ayant une défaillante se pénalisant ipso facto d'eux-mêmes :'-(

Note : je n'ai pas besoin de grammalecte vu que je me relis avant de poster, mais cela peut être utile pour certains (dans Firefox et Libreoffice déjà…). J'ai mes limites, je me restreins à mes habitudes, merci de m'avoir pointé un terme légitime dont je doutais _o/ (il y a peu de monde pour le relever : tu es un grand malade, mais bon on ne se refait pas :p)

[^] # Re: Enfin!

Posté par vpo . Évalué à 3. Dernière modification le 04 octobre 2024 à 22:33.

Etant moi-même un subvocalisateur, je connaissais "subvocaliser". D'où mon étonnement quand, en me citant, vous eûtes substitué icelui par "sous-vocaliser" très cher :-p

Question grammaire et orthographe, faudrait que j'essaie grammalecte car je ne me relis pas assez. Et je suis toujours surpris du nombre de fautes de grammaire (et d'orthographe d'ailleurs) que je peux faire en tapant sur un clavier alors que je ne les ferais pas avec un stylo ! Des participes passés qui deviennent des infinitifs et vice versa, de pluriels sans "s", etc. Et certaines restent même après première relecture, en témoigne celui-ci qui en est particulièrement farci.

Et puis la grammaire, c'est bien utile pour la compréhension d'un texte.

Il y a une subtile nuance entre "oui, je te rembourserai…" et "oui, je te rembourserais…" ;-) Pourtant les deux propositions sont sans faute d'orthographe et grammaticalement justes…

Si je suis le créancier je préfère la première, si je suis le débiteur, je préfère la seconde :-)

[^] # Re: Enfin!

Posté par thoasm . Évalué à 4.

Pourtant à l'oral c'est parfaitement identique en prononciation. Si tu veux mettre de la conditionnalité sans ambiguïté, et à moins de vouloir tromper, il y a plus efficace comme formulation que de tout faire reposer sur la présence ou l'absence d'une lettre muette.

[^] # Re: Enfin!

Posté par vpo . Évalué à 2.

Je parle de texte, pas de conversation.

Il semble que les smileys et l'exemple volontairement choisi sur le point de vue du créancier et du débiteur n'aient pas été suffisant pour faire passer le ton humoristique.

[^] # Re: Enfin!

Posté par Thierry Thomas (site web personnel, Mastodon) . Évalué à 2.

À l’oral je fais très nettement la différence entre le futur, son É pour -AI, et le conditionnel, son È pour -AIS. Je suppose que c’est une question de région.

[^] # Re: Enfin!

Posté par Benoît Sibaud (site web personnel) . Évalué à 4.

(source wiktionary)

[^] # Re: Enfin!

Posté par Ysabeau 🧶 (site web personnel, Mastodon) . Évalué à 4.

Plus précisément qu'il soit possible d'écrire n'importe quel texte et qui ne soit pas du texte-image, illisible par les dispositifs d'assistance ou par les robots. C'est le point le plus important. Et c'est pour cela que des langues avec très peu de locuteurs et de locutrices voient leur système d'écriture ajouté à Unicode. C'est le cas notamment des langues indiennes de cette version de la norme. C'est aussi pour cela que les systèmes d'écriture ancien, comme les hiéroglyphes ou le todhri (qui n'est plus du tout utilisé) sont ajoutés.

« Tak ne veut pas quʼon pense à lui, il veut quʼon pense », Terry Pratchett, Déraillé.

[^] # Re: Enfin!

Posté par barmic 🦦 . Évalué à 4.

Encore faut-il une police pour les prendre en charge.

https://linuxfr.org/users/barmic/journaux/y-en-a-marre-de-ce-gros-troll

[^] # Re: Enfin!

Posté par gUI (Mastodon) . Évalué à 4.

Oui mais il faut bien commencer par le standard sinon la police n'existera jamais.

En théorie, la théorie et la pratique c'est pareil. En pratique c'est pas vrai.

[^] # Re: Enfin!

Posté par Lutin . Évalué à 2.

Avec Nerdfont on a déjà tout ce qu'il faut.

[^] # Re: Enfin!

Posté par Stéphane Bortzmeyer (site web personnel, Mastodon) . Évalué à 2.

Pour certains cas d'usage (indexation, recherche), ce n'est pas nécessaire.

# "Symbols for Legacy Computing Supplement" (1CC00 à 1CEBF) en image

Posté par Jona . Évalué à 9.

"Symbols for Legacy Computing Supplement" (1CC00 à 1CEBF) en image :

https://www.unicode.org/charts/PDF/Unicode-16.0/U160-1CC00.pdf

[^] # Re: "Symbols for Legacy Computing Supplement" (1CC00 à 1CEBF) en image

Posté par L'intendant zonard (site web personnel) . Évalué à 3.

Le 1CE09 va créer plein de problèmes : d'autres marques automobiles vont exiger que leur logo soit intégré à l'Unicode ! ;-)

Intendant, donc méchant, mais libre !

# Fut

Posté par Sylvain Sauvage . Évalué à 2.

« El Hadji Assane Faye, qui fût » de chêne ? 😁

[^] # Re: Fut

Posté par Ysabeau 🧶 (site web personnel, Mastodon) . Évalué à 3.

Corrigé merci.

« Tak ne veut pas quʼon pense à lui, il veut quʼon pense », Terry Pratchett, Déraillé.

# norme de CODAGE des caractères

Posté par Olivier Jeannet . Évalué à 5.

Bonjour,

en anglais c'est encoding, mais en (bon) français on parle de codage, comme pour tous les codes (code Morse, codage de Huffman, codage préfixe, codage entropique, etc).

Sinon, c'est comme dire "crypter" au lieu de "chiffrer".

[^] # Re: norme de CODAGE des caractères

Posté par vpo . Évalué à 4.

Selon:

- Le W3C: "L' encodage de caractères est la clé qui structure les points de code en octets dans la mémoire de l'ordinateur"

- Un site nommé Grafikart: "UTF-8 est un système d'encodage"

- le robert: "Action d'encoder. Encodage des caractères."

- le larousse: "Action d'encoder ; production d'un message ; codage.(…) Informatique Transcription de données d'un format dans un autre : L'encodage d'une vidéo pour le Web, d'un texte en PDF."

Bref, pour le codage des caractères, on parle souvent d'encodage :-)

[^] # Re: norme de CODAGE des caractères

Posté par WalterPolo (Mastodon) . Évalué à 3.

Cela fait longtemps que cela discutaille entre informaticiens francophones sur 'codage' ou 'encodage', sans que j'y aie jamais trouvé mon compte ; par ex., https://sympa.inria.fr/sympa/arc/typographie/1999-05/msg00173.html (et le Jargon informatique de Roland Trique n'aide pas vraiment).

En ce qui me concerne (pour me simplifier la vie, en tant que traducteur), indépendamment du sens lié à 'coder' (programmation) ou aux nuances liées à l'emploi de ces termes dans le domaine du chiffrement, je considère que Unicode est une norme de codage des caractères (représentation informatique d'un objet du monde physique), dont l'implémentation technique correspond à autant d'encodages (utf8, utf16 le et be, 32).

[^] # Re: norme de CODAGE des caractères

Posté par BAud (site web personnel) . Évalué à 3.

correspond à autant

d'encodagesde codes (utf8, utf16 le et be, 32).de rien ;-)

[^] # Re: norme de CODAGE des caractères

Posté par arnaudus . Évalué à 4.

C'est vraiment du culage de mouches…

[^] # Re: norme de CODAGE des caractères

Posté par Faya . Évalué à 2.

J'ai l'impression que ce combat est perdu. En français comme dans toute langue vivante, l'usage fait la loi. Et bien des personnes comprennent immédiatement "crypter" (dans le sens de chiffrer) tandis qu'on m'a déjà demandé de préciser quand j'emploie "chiffrer". Donc en fonction du public, je vais dire crypter ou chiffrer.

[U+1F937]

[^] # Re: norme de CODAGE des caractères

Posté par arnaudus . Évalué à 5.

Et "numérique" vs "digital"? Il faut laisser tomber aussi?

[^] # Re: norme de CODAGE des caractères

Posté par thoasm . Évalué à 3.

Ben dés que tu parles d'école de commerce ou dans le secteur marchand c'est un synonyme de "numérique" effectivement, avec un peu plus la coloration marchande. Ça pique un peu les oreilles mais c'est malheureusement bien installé et ce depuis maintenant pas mal de temps.

# CJC => CCJV, il faudrait arrêter de supprimer le vietnamien

Posté par tao popus . Évalué à 5.

CJC (chinois japonais coréen, calque de l'anglais CJK, en raison de l'ordre alphabétique) devrait être remplacé par CCJV (chinois, coréen, japonais, vietnamien), le vietnamien l'ayant utilisé jusqu'à 1954 et l'utilisant toujours en partie.

On ne dit pas idéogramme, mais sinogrammes (caractères chinois) dans les quatre langues l'utilisant, on parle plutôt de caractères han ce qui est plus juste et est le nom donné dans les quatre principales langues l'utilisant.

Le Viêt Nam fait aussi partie de la 1ère sphère culturelle chinoise (celle qui utilise les caractères chinois qui ne sont pas que des idéogrammes) et à utilisé les caractères chinois jusqu'à environ 1954, lors de don indépendance avec la France. Pourtant si l'invention de cette translittération est plus ancienne, ce sont les français qui ont poussé à apprendre à l'école l'écriture latine pour le vietnamien, mais les 2 systèmes étaient utilisés en parallèle dans les documents officiels.

Les caractères chinois, sont comme en Corée, toujours présent sur de nombreux monuments, et utilisés sur des symboles de fêtes ou religieux. Les érudits confucéens l'apprennent toujours, et on trouve encore quelques sites web en écriture chinoise du vietnamien. Par contre, si la partie CJV est relativement homogène, à la fois dans les formes traditionnelles, et dans les formes simplifiées (à commencé à la fin du XIXe, mais a été plus massif au XXe siècle en japonais , puis encore plus en chinois de chine continentale) le vietnamien se distingue par la création de nombreux nouveaux caractères, suivant toujours les règles étymologiques de construction chinoises, mais apportant de nouveaux caractères.

La Nôm preservation foundation a crée les NomNaTong fonts pour les supporter. Les fontes NOM A et NOM B, qui deviennent dures à trouver apportent aussi une assez bonne partie de ces caractères spécifiquement vietnamien.

On ne devrait pas d'ailleurs dire chinois, mais han, la population chinoise qui utilise les caractères han. Il y a aussi une adaptation au Zhuang, le Sawndip, mais cette langue de la première minorité de Chine (principalement Région autonome zhuang du guangxi, mais également des parties des provinces avoisinantes et au Vietnam), est principalement écrite en latin. Elle fait partie de la famille des (langues kra-dai](https://en.wikipedia.org/wiki/Kra-Dai_languages) de Chine, une famille de langue comprenant le thaïlandais et lao. Ce sous ensemble fait donc partie des langues chinoises, mais pas des langues han qui font partie de la famille des langues sino-tibétaines (le terme sino n'étant encore un fois probablement le plus approprié). Il y a aussi plein de langues au Viêt Nam, Japon (certaines sont éteintes suite au nationalisme des XIXe et XXe), et probablement dans les deux Corées, mais la langue nationale correspond également au nom du pays, dans ces différents cas.

[^] # Re: CJC => CCJV, il faudrait arrêter de supprimer le vietnamien

Posté par Ysabeau 🧶 (site web personnel, Mastodon) . Évalué à 4.

Ce n'est pas à moi qu'il faut le dire, mais au consortium Unicode.

Les sinogrammes sont des idéogrammes, d'une part, d'autre part, c’est beaucoup plus complexe que ça et ça ne se limite pas aux caractères han et tous les idéogrammes des blocs Unicode CJC ne sont pas des sinogrammes.

Pour le reste, langue et système d'écriture sont des notions différentes. Une langue peut s'écrire dans plusieurs systèmes d'écriture, c'est le cas du Wolof notamment. Et, bien évidemment, un système d'écriture peut être utilisé pour plusieurs langues, c'est le cas de l'alphabet latin ou du Braille.

« Tak ne veut pas quʼon pense à lui, il veut quʼon pense », Terry Pratchett, Déraillé.

# Complexité

Posté par karteum59 . Évalué à 6. Dernière modification le 23 octobre 2024 à 01:42.

Rien de très nouveau pour ceux qui connaissent bien le sujet, mais j'ai appris énormément de choses avec ce post (le même en VO) sur la complexité d'Unicode, la nuance entre caractère, point code et graphème ("un point-code n'est pas toujours un caractère unique" alors que naïvement je pensais au départ qu'un bloc de 32 bits en UTF-32 représenterait toujours un caractère…).

[^] # Re: Complexité

Posté par Christophe "CHiPs" PETIT (site web personnel) . Évalué à 2. Dernière modification le 23 octobre 2024 à 12:02.

NB : le lien correct en VO est https://tonsky.me/blog/unicode/

Suivre le flux des commentaires

Note : les commentaires appartiennent à celles et ceux qui les ont postés. Nous n’en sommes pas responsables.