En France, la captation d'images dans les lieux publics est légale sans nécessiter le consentement des personnes qui peuvent être enregistrées1. Cependant leur reproduction et diffusion, elles, requièrent l'accord de toutes les personnes concernées2. Ainsi, si on peut filmer la rue dans une relative insouciance, les choses se compliquent lorsqu'on veut partager les images. Il convient d'assurer l'anonymat des personnes qu'on peut reconnaître.

Je cherchais donc depuis quelques temps une manière de flouter tous les visages qui apparaissent dans une vidéo. La tâche n'est pas aisée : il faut repérer toutes les têtes, sur toutes les images qui composent une vidéo, puis appliquer un traitement vidéo. Mon téléphone n'étant pas très puissant, j'ai préféré l'épargner de ces lourdes tâches et j'ai concentré mes recherches sur ordinateur.

Au final, j'ai trouvé deface qui est très efficace dans cet exercice. C'est un projet en Python 3 et il s'installe en une commande pip. Il s'utilise en une ligne de commande : deface ma_vidéo.mp4, qui va générer sans écraser l'original une version anonymisée de la vidéo (dans ma_vidéo_anonymized.mp4). La détection est solide; avec les paramètres par défaut, il faut qu'un visage soit vraiment tourné hors de l'axe caméra pour ne pas être pris en compte. En modifiant le seuil (avec le paramètre --thresh), on peut même les repérer eux aussi.

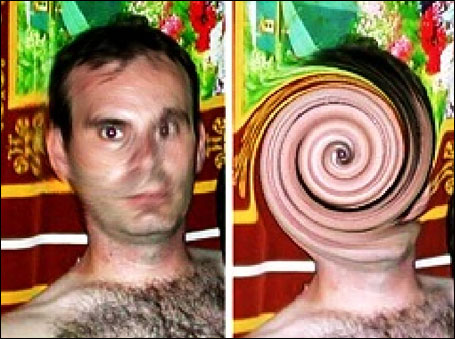

Voici un exemple. Il a originellement été tourné en 720p/30fps; mais pour embarquer l'extrait j'ai dû faire un GIF de 2 secondes en 480p/3fps…

Le seul paramètre que j'ai utilisé est --thresh 0.075, car avec la valeur par défaut (0.2, ce qui est moins sensible), sur une ou deux trames seulement, le visage de la femme au premier plan n'était pas repérée. Il l'est maintenant, alors qu'on ne voit même pas ses yeux, cachés par le casque. Vous pouvez également constater que l'algorithme cible beaucoup de visage qu'on ne pourrait même pas identifier sans le flou : chevelure masquée par le casque, personne tournée perpendiculaire voire presque dos à la caméra, bébé avec un casque… Quasiment aucun faux positif, sur le gif on voit juste celui sur une dame qui surgit des colonnes au fond à gauche, dans la vidéo elle a son corps flouté sur quelques trames. En pinaillant avec le seuil je pense qu'on peut atteindre un résultat parfait, surtout si on est à l'aise à l'idée de montrer quelques visages tournés à plus de 135 degrés de l'axe caméra. Le temps d'analyse et d'encodage sont proches de ceux de ffmpeg seul, si nécessaire il y a des possibilités d'accélération matérielle.

Si un jour je me sens d'humeur sadique, je l’essaierai sur le terminal de mon pauvre téléphone android.

Amusez-vous bien !

# non caucasiens

Posté par Gil Cot ✔ (site web personnel, Mastodon) . Évalué à 5.

Très intéressant ce petit utilitaire, et c'est époustouflant le résultat.

Petite question qui me vient à l'esprit dans l'immédiat : ça marche tout aussi bien quelque soit le type de peau ?

“It is seldom that liberty of any kind is lost all at once.” ― David Hume

[^] # Re: non caucasiens

Posté par Élafru . Évalué à 5.

Très bonne question, ça reste à tester. Pour ce que ça vaut, WIDER FACE, le jeu de données utilisé pour l'entraînement, a l'air d'avoir non seulement tout type de peau, mais aussi des visages complètement maquillés.

# Oui mais non, je ne veux pas vivre dans ce monde

Posté par Thomas Debesse (site web personnel, Mastodon) . Évalué à 10.

Alors cette formulation est problématique, en tout cas en supposant le droit français (je reconnais la rue de Rivoli à Paris sur les clichés). Et tu écris en note de bas-de-page, « Il existe des exceptions pour les personnalités publiques, les sujets d'actualité, ou même des types de prises de vue où le cadrage n'isole aucune personne en particulier… », donc tu semble connaître le sujet, mais la formulation inverse et mélange certaines choses. Je ne dis pas que c’est volontaire de ta part, c’est peut-être le reflet de ce qui se dit dans ton entourage et c’est un certain reflet de notre société en fait.

Si on peut dire que par défaut la protection de la vie privée exige une autorisation, le cadrage n’est pas au premier abord une exception à la protection de la vie privée. L’exception est la liberté d’informer. Et les questions de cadrage, de personnalité, etc. ne viennent pas encadrer la protection de la vie privée, mais viennent encadrer la liberté d’informer. Cette nuance est très importante.

Par exemple dans les images présentés, je suppose qu’il s’agit d’une manifestation publique dans un lieu public. Le droit à l’information prévaut. Si l’ont peut considérer le droit à l’information comme une exception en général, pour cet événement et les clichés relatifs, c’est le droit d’informer qui prévaut, et les exceptions se considèrent à partir de ceci.

S’il est juste que les prises de vue en public où le cadrage n’isole aucune personne en particulier ne doit pas poser problème, la formulation du journal laisse supposer que les images prises dans un lieu public sont interdites de reproduction par défaut sauf pour certains cadrages.

Alors qu’en fait, dès lors qu’il est constaté qu’on représente un événement public, ceci devient la nouvelle base du discernement. Les questions de cadrage ou de notoriétés se discutent alors sur cette nouvelle base.

Le journaliste qui revient de manifestation ne va pas examiner toutes les photos avant de les verser sur le serveur de son journal, il sait que ce sera à la rédaction de considérer que l’une ou l’autre n’est pas publiable. Mais toujours sans examiner les photos préalablement ce même journaliste ne va pas verser sur le serveur de son journal les photos prises à l’occasion de l’anniversaire de sa fille, éventuellement il peut identifier une exception. Et dans les deux cas, il n’y a donc pas besoin de floutage préalable, et donc pas de floutage automatique de tout ce qui n’est pas un cadrage isolé.

Comme écrit sur cette page de la CNIL:

Lieux public ? Rue ? Par défaut tu peux, et il y a l’exception des cadrages isolés.

Ce n’est pas « seuls les cadrages généraux ne nécessitent pas de floutage » ou autre formulation de ce type.

D’ailleurs, il s’agit alors de simples « images prises dans un lieu public », pas même d’un événement et autre manifestation qui induisent une certaine représentation et une information.

Et l’exception de la notoriété, elle n’est pas là pour permettre de diffuser une image d’un événement public, le seul droit à l’information suffit déjà. Cette exception de la notoriété permet justement d’être encore plus assuré dans son droit à diffuser.

Comme écrit ici :

Et ce n’est pas qu’une question de personne politique, comme dans cet exemple donné par cet article (1997…) :

Dans cet exemple on a une participation publique dans un lieu privé, et pourtant le droit d’informer s’applique. De même, nul n’est sensé être inquiété pour avoir diffusé un cadrage isolé d’Emmanuel Macron faisant un discours politique. C’est là qu’on voit que l’exception de la notoriété n’est pas une exception au droit à la protection de la vie privée, mais une exception à ce qui limite le droit d’informer.

Sachant que même la question du cadrage isolé est assez floue. Il y a une différence entre publier une photo prise dans un lieu public, et informer d’un événement public. Si tu couvres une manifestation de la CGT et que tu vois sur une pancarte intéressante et que tu zoom dessus, il y a des chances que le porteur de la pancarte fasse partie du cadrage. À quel moment le cadrage est isolé ? As-tu isolé la personne, ou isolé la pancarte ? Représentes-tu la pancarte, ou la personne ? Autre exemple : sur tes images, tu as diverses personnes, dont des personnes au premier plan (c’est logique et difficilement évitable), mais c’est aussi une vidéo. Si dans les images suivantes de la vidéo pendant que tu promènes ta caméra à un moment il y a une personne qui passe juste devant toi et qu’elle occupe l’essentiel du cadre, dois-tu flouter cette personne qui semble constituer un cadrage isolé ? Si dans cette même manifestation publique dans un lieu public, t’as des gens qui viennent casser la gueule aux manifestants, et qu’à ce moment dans ta série de photo tu as des photos dont le cadrage est principalement centré sur les agresseurs et leurs postures, dois-tu flouter ?

Ce n’est pas « par défaut c’est interdit et dans l’éventualité où le cadrage n’est pas isolé, c’est permis ». C’est « par défaut c’est interdit sauf pour informer ». Et une fois que c’est établi qu’il s’agit d’informer, c’est « par défaut c’est autorisé sauf si on peut prétendre que ça sort de certains cadres ».

Et une certaine économie de moyen est profitable.

Je n’ai pas envie que les gens croient à tort que la reproduction et diffusion d’image prise dans la rue requièrent de flouter tout le monde, et que cette confusion minerait toute opposition à d’éventuels projets de loi qui contraindraient à un telle débauche de ressources.

Je pense que l’homme a un certain devoir de prévenir la débauche de ressources et de réduire les coûts d’exploitations, et ça passe par ce genre compromis. Événement public ? Supposer par défaut que c’est possible, puis traiter au cas par cas, ce que fait la loi actuellement. De même, permettre la diffusion a priori, et le retrait a posteriori, ce que fait la loi actuellement.

Parce que si la captation est différente de la diffusion, la demande de retrait est aussi différente de la diffusion et par principe, la demande de retrait succède à la diffusion.

Bref, c’est un chouette logiciel, bravo ! J’en aurai peut-être l’usage moi-même dans certains cas.

Mais il n’est pas nécessaire de créer ou augmenter artificiellement des peurs pour rendre son produit plus attractif, et j’espère qu’on ne nous pondra pas des lois obligeant à utiliser un ordinateur (pour commencer) et à utiliser des algorithmes de ce type avant toute publication de photo prises dans la rue.

Après je ne dis pas que c’est toi qui crée ou augmente artificiellement ces peurs, tu ne fais peut-être que retranscrire ce qu’on t’a dit.

Je trouve ce glissement très intéressant, c’est pourquoi j’ai cité cet article de 1997. En 1997 il était impensable pour tout un chacun de pouvoir imaginer flouter automatiquement tous nos clichés. Je pense que ça nous révèle quelque chose de précieux : l’économie de moyen est directement liée à nos ressources, mais ce n’est pas parce que des moyens nouveaux apparaissent ou qu’on vit dans une bulle technologique privilégiée qu’on doit renoncer à cette économie de moyen.

C’est un peu comme les citoyens qui contrôlent d’autres citoyens avec des certificats numériques pour manger ou se divertir, ce n’est pas parce que la technologie nous permet cette débauche technique et ces privations de droit qu’on doit nécessairement accepter cette débauche technique et ces privations de droit.

La vie privée c’est important, mais on n’est pas obligé d’encourager la construction d’un monde où toute photo doit être filtrée et modifiée préalablement à la publication.

Et à l’époque du port du masque dans l’espace public et dans l’espace privé, rajouter avec ça le floutage indiscerné des visages ? non, s’il vous plaît. Je ne rêve pas d’un monde où le visage humain n’existe plus.

Oui mais non, je ne veux pas vivre dans ce monde, je ne veux pas de débauche de moyen.

Oui mais non, je ne veux pas vivre dans ce monde, nos visages sont beaux !

Cette phrase aussi me surprend et semble témoigner de changements dans la manière de percevoir les choses : « des types de prises de vue où le cadrage n'isole aucune personne en particulier », le selfie a-t-il pris une place si importante que le portrait est désormais considéré comme un présupposé dans l’exercice de la photographie si on ne précise pas, et que la photo non-portrait serait une forme particulière de photo qu’il faudrait désormais relever ?

En école d’art, l’élève doit-il désormais préciser que « ce n’est pas un portrait » quand il étudie des photos, plutôt que de préciser que « c’est un portrait » quand c’en est un ?

La personne humaine est-t-elle si centrée autour d’elle-même pour que prendre une photo d’un lieu public, d’une foule, d’un paysage, d’une fleur, d’un cheval ou d’une conjonction planétaire devienne « un type de prise de vue où le cadrage n’isole aucune personne en particulier » ?

À noter que le droit à l’image s’applique aussi pour les biens dans certains cas (et on semble aller vers un durcissement) :

Voulez-vous d’un monde où une photo dans la rue et autre lieu public, où une photo photo d’événement public doit être préalablement passée au travers d’un algorithme qui floute automatiquement les visages, les bâtiments et jardins ?

ce commentaire est sous licence cc by 4 et précédentes

[^] # Re: Oui mais non, je ne veux pas vivre dans ce monde

Posté par Sytoka Modon (site web personnel) . Évalué à 10.

D'ailleurs, heureusement qu'on ne floute pas à chaque fois, c'est ainsi que Benalla s'est fait chopé à faire des choses qui n'était pas du tout dans sa fiche de poste !

[^] # Re: Oui mais non, je ne veux pas vivre dans ce monde

Posté par Yth (Mastodon) . Évalué à 6.

Pourtant sa fiche de poste c'était pas « kéké flambeur ambiance 007 » ?

Rhaaa, mais c'est pour ça, il a lu la fiche de perso de sa dernière murder-party…

[^] # Re: Oui mais non, je ne veux pas vivre dans ce monde

Posté par Gil Cot ✔ (site web personnel, Mastodon) . Évalué à 1. Dernière modification le 21 septembre 2021 à 14:19.

Ici c'est juste la section mono zéro : permis de tabasser à mort…

Sorte de hooligan avec un laisser-passer (cf. pirate vs corsaire.)

“It is seldom that liberty of any kind is lost all at once.” ― David Hume

[^] # Re: Oui mais non, je ne veux pas vivre dans ce monde

Posté par anaseto . Évalué à 5.

On voit tout de suite celui qui ne sort pas de chez lui correctement triple-masqué… En 2021, le sourire, le nez, c'est dépassé tout ça, on ne montre plus son intimité faciale en public, ce n'est pas poli, ça ne se fait pas. La question du floutage ne devrait même plus se poser, elle répond à un problème archaïque d'une époque indécente où les gens n'avaient aucune pudeur. /s

[^] # Re: Oui mais non, je ne veux pas vivre dans ce monde

Posté par Élafru . Évalué à 10.

Merci pour ton commentaire très intéressant. Pour bien déclarer la chose, je n'ai absolument aucune formation en droit, je me suis juste souvent intéressé à la question de la captation/diffusion d'images dans la rue (notamment dans le cadre d'une caméra embarquée sur véhicule); et j'ai eu une seule fois une discussion très brève avec un avocat sur le sujet.

Comme tu l'as deviné, oui il s'agit d'une manifestation à laquelle j'étais présent. J'ai pris cette vidéo car elle me paraît être un bon test de la technologie (plein de visages un peu masqués par les casques, dans des angles différents, aucune stabilisation, capteur 720p/30fps grand public…). Mais effectivement, je ne pense pas que le floutage soit nécessaire légalement dans ce cas, c'était un événement déclaré en préfecture, etc.

Du point de vue des affects autour des technologies d'anonymisation devenues si accessibles, j'entends bien ta vision. En fait pour être honnête, l'aspect légal ne m'importe pas tant que ça; est-ce que je risque vraiment, en pratique, de me retrouver un jour dans un tribunal judiciaire à devoir expliquer pourquoi je n'ai pas flouté Tartempion?

En fait j'ai plus tendance à voir l'inverse : l'anonymat comme pouvoir. L'État a l'air plutôt d'accord avec moi, d'où la tentative de l'imposer pour la police avec la loi sécurité globale. Il y a chez certaines personnes la peur du fichage des manifestations, et la crainte de représailles dans leur vie personnelle, professionnelle, administrative. Moi-même j'ai souvent envie de grossir les rangs d'une manifestation que je juge juste, sans vouloir que quelque part, une liste contienne explicitement mon nom, prénom, et date de naissance parce que j'y ai été reconnu. Alors quand je vais en manifestation, j'ai beau me comporter raisonnablement, j'éteins mon téléphone, et je suis bien content de porter un bonnet pour le froid, ou un masque pour la pandémie, car ça va flinguer les tentatives de reconnaissance faciale. Bref, si je venais à partager sur les réseaux sociaux ce genre d'image de manifestation, je flouterais dans l'idéal les citoyens présents pour les protéger, mais pas les agents dans l'exercice de leurs fonctions.

[^] # Re: Oui mais non, je ne veux pas vivre dans ce monde

Posté par Gil Cot ✔ (site web personnel, Mastodon) . Évalué à 2.

les citoyens présent pour les protéger,

mais(y compris) les agents dans l'exercice de leurs fonctions [; excepté les gens qui débordent d'un côté ou d'un autre.]“It is seldom that liberty of any kind is lost all at once.” ― David Hume

# Note

Posté par Psychofox (Mastodon) . Évalué à 10. Dernière modification le 21 septembre 2021 à 09:30.

Note: flouter le visage ne garantit pas l'anonymat d'une personne. Dans certains cas on peux reconnaitre plein de gens rien qu'à l'association de leurs habits et leur façon de marcher, dans le cas de l'exemple pédaler à vélo ou le modèle exact et la config de vélo ou de tout autre type de véhicule/accessoire.

[^] # Re: Note

Posté par Panhwein . Évalué à 8. Dernière modification le 21 septembre 2021 à 11:36.

Oui!

Mais je me pose une question sur l'efficacité du schmilblick.

Dans certaines affaires ou des suspects avaient utilisé des effets photoshop, adobe à tout

simplement fournie les algorithmes des filtres en question.

Après un peu de reverse, ils ont reconstitué les visages et les personnes ont pu être identifier.

Rien ne vaut un beau rectangle noir.

[^] # Re: Note

Posté par Panhwein . Évalué à 6.

Ah j'avais pas vu, on peut mettre des carrés noirs.

Très intéressant, merci pour ce journal!

# Mauvaise cible pour le floutage ?

Posté par ǝpɐןƃu∀ nǝıɥʇʇɐW-ǝɹɹǝıԀ (site web personnel) . Évalué à 2.

Un peu plus haut il nous a été expliqué qu'il n'était pas nécessaire de flouter les visages avant publication (sous réserve d'une bonne compréhension). Mais qu'en est-il des bâtiments et plus généralement des objets, voire des plantes taillées et autres jardins ? Ne sont-ils pas le reflet de la personnalité de leurs auteurs ? Et partant ne doit-on pas obtenir l'accord des ayants-droits, ne serait-ce que pour prendre les photographies, sans même imaginer s'autoriser à les publier ? Ou bien y a-t-il quelque exception salutaire là aussi ?

Vraisemblablement un mécanisme de type usage/copie privé/e s'appliquera pour des photographies non publiées. Mais qu'en est-il des autres ? Du coup n'aurait-il pas fallu flouter les bâtiments, les vêtements…

« IRAFURORBREVISESTANIMUMREGEQUINISIPARETIMPERAT » — Odes — Horace

[^] # Re: Mauvaise cible pour le floutage ?

Posté par Yth (Mastodon) . Évalué à 2.

Ben ça c'est assez facile :

* si c'est directement visible depuis la voie publique : c'est publiquement accessible. (Tautologie détectée…) ;

* sinon, c'est privé.

Un peu sur le principe de : tu ne peux pas empêcher les gens d'utiliser leurs yeux là où ils ont le droit de se trouver.

Pour la publication, c'est probablement plus compliqué, mais a priori si c'est publiquement visible, c'est publiable, tu ne peux pas empêcher une façade, une haie, un jardin ouvert, etc, d'être pris en photo depuis la voie publique.

Attention : c'est très probablement différent si tu fais ça depuis une autre propriété privée, genre l'immeuble d'à côté qui a une vue plongeante au dessus du mur.

Et non, les arbres, buissons et autres murs, ou portails en fer forgés, peintures murales, etc., n'ont pas de droit à l'image…

[^] # Re: Mauvaise cible pour le floutage ?

Posté par Gil Cot ✔ (site web personnel, Mastodon) . Évalué à 3.

Comme expliqué ailleurs, que ce soit publiquement visible ne rend pas la chose publiable si on n'est pas en train d'apporter une information… (mieux si la photo n'avait pas été prise dans/avec ce/cet contexte/objectif ?)

“It is seldom that liberty of any kind is lost all at once.” ― David Hume

[^] # Commentaire supprimé

Posté par Anonyme . Évalué à 8. Dernière modification le 21 septembre 2021 à 14:59.

Ce commentaire a été supprimé par l’équipe de modération.

[^] # Re: Mauvaise cible pour le floutage ?

Posté par Sytoka Modon (site web personnel) . Évalué à 6.

Ben oui, je pense qu'il faut effectivement flouter toutes les personnes sur un film ou une photographie, puis il faut aussi absolument remplacer tous les objets et le fond par un décor artificiel généré aléatoirement.

# Risque de déconvolution ?

Posté par freejeff . Évalué à 4.

Est-il assuré que l'on ne puisse pas dé-flouter les visages ?

Si l'algo est ouvert, alors trouver la meilleure déconvolution sur la séquence d'image semble possible, non ?

Un pédocriminel avait été arrêté, car il avait appliqué une déformation en spirale sur sa photo, et la police scientifique avait réussi à trouver la transformation inverse et reconstituer sa photo !

La c'est encore plus simple !!

Du coup, quelle est la sécurité associée à ce genre d'outils ?

Bon après je n'ai que très peu joué avec les outils de déconvolution, donc ce n'est peut être pas si simple !!

[^] # Re: Risque de déconvolution ?

Posté par Panhwein . Évalué à 5.

Exactement.

Le filtre swirl de photoshop. On parle bien de la meme affaire!

Il avait transformé son visage en… spirale!

Photoshop a donné l'algo au fbi.

Oui sur du libre, c'est plus simple, mais ca à l'air de bien fonctionner avec des trucs en noir.

+1

[^] # Re: Risque de déconvolution ?

Posté par Panhwein . Évalué à -7. Dernière modification le 21 septembre 2021 à 17:05.

Mettez moi des -1, si je touche -42, je m'inscrit à pole emploie

[^] # Re: Risque de déconvolution ?

Posté par Thomas Debesse (site web personnel, Mastodon) . Évalué à 10.

Tu parles du logo Debian ? Je le savais !

Pour ceux qui débarquent, le logo “swirl” de Debian est fait avec une brosse d’Adobe Illustrator (que certains confondent avec Photoshop par bouche à oreille) :

Petit montage trouvé ici qui résume en une seule image l’image en pièce jointe et les divers commentaires des mails cités :

Ironiquement ce logo Debian est celui considéré comme libre. Oui parce qu’en fait Debian a un logo non-libre, mais personne ne le connaît vu que si c’est pas libre, c’est compliqué à utiliser. À noter que ce « Debian Open Use Logo » (celui qu’on voit partout) est sous GPlv3, mais il semble que ça n’a pas été toujours le cas (il était sous “Debian Open Use Logo License” si je comprends bien, et la liberté de cette licence était remise en cause).

le lien a tendance à casser, avant c’était

ici, en voici une copie au cas où. ↩ce commentaire est sous licence cc by 4 et précédentes

[^] # Re: Risque de déconvolution ?

Posté par ǝpɐןƃu∀ nǝıɥʇʇɐW-ǝɹɹǝıԀ (site web personnel) . Évalué à 5.

Sauf erreur, les filtre de flou perdent de l'information (en éliminant certaines fréquences, en ajoutant du bruit…). Reconstruire une information absente paraît délicat.

« IRAFURORBREVISESTANIMUMREGEQUINISIPARETIMPERAT » — Odes — Horace

[^] # Re: Risque de déconvolution ?

Posté par SChauveau . Évalué à 10.

En effet. Un floutage réduit drastiquement la quantité d'information disponible alors qu'un filtre comme swirl se contente de déplacer les pixels en conservant la quasi totalité des informations. Inverser un floutage me semble donc très difficile ou même impossible.

Par contre, cela peut probablement s'envisager sur une vidéo. Un algorithme futé devrait pouvoir reconstituer assez fidèlement les détails d'un visage en combinant plusieurs dizaines ou centaines d'images floutées.

D'une certaine façon, c'est déjà ce que fait le cerveau avec les vidéos en basse résolution. Individuellement chaque image peut sembler floue et bruitée mais l'animation fait apparaître des détails.

Ce genre de technique existe aussi en astronomie où des centaines d'images de mauvaise qualité peuvent être combinées pour produire une image haute résolution.

[^] # Re: Risque de déconvolution ?

Posté par freejeff . Évalué à 2.

Tout les arguments sont valides mais la conclusion est discutable. La vrai quesiton est celle de la réversibilité de la perte d’entropie de l'image. C'est justement le point des méthodes de déconvolution. Si il est clair qu'un calcul d'entropie avant et après donnera des résultats différents, il n'est pas si évident que l'opération inverse ne soit pas accessible dans une certaine mesure. Les questions sont est-ce que la quantification des niveaux de gris (codage sur 3*8bits ) entraîne une irreversilité et est-ce que la transformation en vidéo (probablement h26{4|5}) apporte une sécurité suffisante si quelqu'un s'amuse à essayer de reconstruire les visages.

[^] # Re: Risque de déconvolution ?

Posté par AlexTérieur . Évalué à 2.

On ne peut pas reconstituer une information qui a été "détruite", c'est en dehors des théories de la physique. N'importe quel filtre de floutage est destructeur, donc c'est physiquement impossible de reconstituer une image parfaitement identique à elle-même après sa "destruction".

La seule possibilité de s'en approcher est d'utiliser des IA, et encore, il ne faut pas que le filtre appliqué ait été trop important (trop de flou, trop de mélange et/ou déformation). Dans l'exemple du journal, le flou est tellement important qu'on n'arrive même pas à distinguer l'implantation des yeux, donc aucune chance même pour l'IA la plus sophistiquée de reconstituer un visage, en tout cas qui ressemble à la personne de départ.

[^] # Commentaire supprimé

Posté par Anonyme . Évalué à 5.

Ce commentaire a été supprimé par l’équipe de modération.

[^] # Re: Risque de déconvolution ?

Posté par AlexTérieur . Évalué à 0. Dernière modification le 22 septembre 2021 à 14:55.

Oui et non. Sur l'exemple même c'est trop évident. Si sur certains visages floutés on verrait ne serait-ce qu'un petit pâté de pixels plus sombres que les alentours dont on pourrait fortement supposer que ce sont les yeux, je n'aurai rien dit. Ici on n'arrivera à rien. A l'inverse, à trop vouloir critiquer l'homme (sur sa physiologie/biologie j'entends), c'est aussi une fausse bonne idée.

[^] # Commentaire supprimé

Posté par Anonyme . Évalué à 6.

Ce commentaire a été supprimé par l’équipe de modération.

[^] # Re: Risque de déconvolution ?

Posté par AlexTérieur . Évalué à 1.

L'exemple "Wikipedia" ne parle pas pour vous je crains…

Dans l'exemple on distingue très clairement l'orifice de détonation de la balle même sur l'image "floutée" (je mets volontairement entre guillemets parce que pour moi ce n'est pas un filtre de flou mais de "bougé"). Désolé mais va falloir trouver des exemples plus convaincants.

[^] # Commentaire supprimé

Posté par Anonyme . Évalué à 3. Dernière modification le 23 septembre 2021 à 16:02.

Ce commentaire a été supprimé par l’équipe de modération.

[^] # Re: Risque de déconvolution ?

Posté par AlexTérieur . Évalué à -1.

[^] # Commentaire supprimé

Posté par Anonyme . Évalué à 4.

Ce commentaire a été supprimé par l’équipe de modération.

[^] # Re: Risque de déconvolution ?

Posté par freejeff . Évalué à 7.

Sur le swirl, c'est bien plus compliqué que ça.

Toute transformation d'image n'est pas inversible. Les transformations d'images inversibles continues et à dérivées continues sont appelées difféomorphe, elles sont le seules à garantir l'inversibilité, permettant de reconstruire l'image.

L'exemple du swirl est assez parlante (attention, image dérangeante):

On voit bien que la reconstruction n'est pas parfaite, alors que pour le coup je pense que la fonction est difféomorphe, si on en prend la définition de skimage, car c'est une exponentielle sur les coordonnées polaires.

Donc, même dans ce cas favorable, la quantification, rend la reconstruction possible, mais pas parfaite. Pour moi c'est bien plus difficile que le simple flou que l'on voit sur les images !

Pour info l'identification de la fonction de transformation d'une image vers une autre s'appelle le recalage d'image (Image Registration, DIC, PIV, Optical Flow), j'ai fait des articles sur ce sujet ici même, et je peux garantir, que sans l'algorithme, personne ne saurait retrouver la transformation inverse, c'est juste irréaliste !

[^] # Re: Risque de déconvolution ?

Posté par barmic 🦦 . Évalué à 2.

En 4ème, j'ai eu 12 de moyenne. Quelles étaient mes notes de français ?

https://linuxfr.org/users/barmic/journaux/y-en-a-marre-de-ce-gros-troll

[^] # Re: Risque de déconvolution ?

Posté par freejeff . Évalué à 6.

Désolé, mais j'ai peut être été un peu rapide.

un flou n'est pas une moyenne et peut être représenté mathématiquement par une convolution. Une moyenne prend N valeur et en retourne 1, la convolution prend N valeurs et en retourne N via une relation avec son voisinage.

Il existe un pan de l'analyse d'image qui travaille à des stratégies de déconvolution, qui permettent de déflouter les images par exemple.

Il s'agit de trouver une fonction d'étalement du point (point spread function PSF) qui est en somme la représentation de la convolution et de l'appliquer à l'image par des méthodes telles que la déconvolution de Wiener.

Il en existe plein pour par exemple corriger des flous de bougé, lorsque l'on ne connaît pas la trajectoire, il faut la retrouver, cela s'appelle à déconvolution aveugle.

Lorsque l'on connaît la fonction de convolution il est assez simple de déconvoluer. Et comme c'est du LL, il est simple d'aller regarder le code du flou et de fabriquer un psf.

Après, c'est vrai que la déconvolution n'est jamais parfaite, pas (plus qu'une transformation géométrique inverse ne conservera parfaitement les niveaux de gris), le fait de sauver une image avec un format destructeur avec des niveaux quantifié sur 8 ou 10 bits, peut faire que la déconvolution crée des hautes fréquences parasites qui la rendront inopérante …

C'était sur ce point que je me posais des questions, mais il est vrai que je n'avais pas pris le temps de bien poser le problème.

Il existe aussi des algorithme de superrésolution sur des vidéos qui associés à la déconvolution pourraient régulariser le problème.

De manière générale, il est sain d'éviter de penser que la personne qui écrit quelque chose est une abrutie et de faire un raisonnement par l'absurde faux derrière, mais bon vous n'avez pas été le seul :

Il n'est pas question d'être identique, mais de pouvoir reconnaître un visage, cela fait une très grosse différence.

De plus sur un signal continu, il est assez simple d'inverser la convolution, le fait que le signal soit quantifié, et ensuite compressé destructivement, doit probablement réduire les chances de pouvoir recréer une image acceptable.

Il faudrait tester, on est souvent surpris, mais il est très probable que cette personne ait raison. Il n'est par contre absolument pas nécessaire d'utiliser de l'IA, lorsque l'on a la donnée de sortie et le modèle. On résout des problèmes mal posés depuis des siècles (merci Hadamard), appeler l'IA, dès que l'on n'a pas envie de réfléchir est un peu facile.

J'avais lu cette publi, il y a quelques années, mais il est vrai que le niveau de convolution ici, est bien plus élevé. Mais comme on n'a pas la PSF, celle identifiée est forcément moins précise qu'une que l'on peut reconstruire avec un algo.

Donc pas si trivial au final.

[^] # Re: Risque de déconvolution ?

Posté par AlexTérieur . Évalué à -1.

Attention de ne pas prêter des intentions je n'ai pris personne pour un abruti et je suis parfaitement conscient des progrès sur ces problématiques, et je comprends les inquiétudes. C'est plutôt sur les fantasmes qui en découlent que je réagissais.

Attention aussi aux confusions : "deconvoluer" une image ça n'est pas la même chose que faire des corrections d'images d'observation astronomique.

Faire une déconvolution va peut-être aider éventuellement une IA en réduisant le champ des possibilités, mais sûrement pas à faire des miracles. Si l'image est trop destructurée tu peux y appliquer toutes les techniques incroyables ça ne t'emmènera pas loin.

Tout ce qu'on va avoir droit c'est des recommandations sur le floutage des images un peu comme on a eu pour les mots de passe.

[^] # Re: Risque de déconvolution ?

Posté par freejeff . Évalué à 3.

Ce n'est pas vous mais barmic :

Ces petites blagues sur le dos des gens, sans chercher à comprendre, sont agaçantes, mais cela n'a rien de grave, juste un peu agaçant.

Confus. Il y a d'autres corrections dans l'analyse d'image astronomiques que la déconvolution, mais celle-ci en fait partie.

Non, de ce que j'ai lu (mais c'est pour moi un sujet marginal d'intérêt), la plupart des algos d'IA sur la déconvolution travaillent à chercher la PSF, en partant du principe que le flou de bouger se traduit par une "trajectoire" à identifier, car celle-ci peut se traduire par une PSF dédiée. Il s'agit donc de trouver le mouvement qui a eu lieu entre le moment où l'on a commencé à intégrer le flux rayonné, et le moment où on a arrêté. Trouver une trajectoire spatio-temporelle avec comme seul indice le résultat en terme de flou est un problème mal posé. Sur les problèmes mal posés, l'IA peut apportés beaucoup pour éviter les minimums locaux, et trouver le bon espace d'exploration à moindre coût.

Sur des images sans flou de bougé mais avec un flou, dont on ne peut pas avoir d'autre représentation des objets qu'avec la seule modalité floutée, alors, il y a sûrement du travail qui peut être fait en IA sur l'identification de la PSF.

Lorsque l'on peut aller lire le code de floutage, reconstruire la PSF, ne doit pas être bien difficile.

En bref, je suis d'accord avec les autres moules, le plus sûr est le carré noir. C'est une destruction certaine de l'information, nécessaire à la reconnaissance, pour le flou, il faudrait y passer un temps important pour trancher.

[^] # Re: Risque de déconvolution ?

Posté par barmic 🦦 . Évalué à 2. Dernière modification le 22 septembre 2021 à 22:39.

J'avais préféré ne pas répondre pour ne pas risquer d'envenimer. Je comprends que tu n'ai pas apprécié mon message. Je ne tiens pas à en débattre. Mais expliquer que je fais des blagues dans ton dos, c'est faux et tu me prête un comportement et une volonté que je démens. Tu n'aime pas les petites phrases c'est compréhensible, mais si tu monte sur tes grands chevaux et que tu souhaite m'expliquer comment avoir des échanges sains (« De manière générale, il est sain d'éviter de penser que la personne qui écrit quelque chose est une abrutie et de faire un raisonnement par l'absurde faux derrière, mais bon vous n'avez pas été le seul ») évite peut être de prêter de mauvaises intentions comme cela aux autres.

Bref.

https://linuxfr.org/users/barmic/journaux/y-en-a-marre-de-ce-gros-troll

[^] # Re: Risque de déconvolution ?

Posté par freejeff . Évalué à 0.

Et bien, si :

c'est monter sur ses grands chevaux … Du coup, il n'est pas possible de signifier son agacement dans un échange ?

Ton exemple était faux, et ta tournure de phrase :

sous-entend explicitement qu'un enfant que 15 ans (4ième) n'aurait pas fait une telle erreur …

Il me semble l'avoir expliqué ton erreur de raisonnement de manière non condescendante et non agressive.

Ton post est inutilement désagréable, du coup si ce n'est pas de l'humour au dépend d'une personne qu'est-ce ?

Après, c'était peut être une réponse trop rapide. Tu considères que je te prête "un comportement et une volonté que tu démens", soit, mais du coup le sens de ton commentaire m'échappe totalement. Je t'ai juste signifié que ta blague m'avait agacé et que visiblement, tu n'avais pas compris la teneur de mon questionnement, mais sur ce point, c'est bien ma faute, que de ne pas avoir bien posé le problème.

La bienveillance des échange est bien souvent conditionnée par leurs antécédents. Il est clair que j'ai fait le choix de te signifier que tu m'avais agacé, tout en exprimant que ce n'était pas grave.

Du coup, je ne vois pas trop le problème.

Par contre, je n'ai pas mis d'intention, ta phrase semble être humoristique et tourne en dérision mon questionnement, sans que tu n'aies pris le temps de le comprendre. C'est une interprétation et pas un procès d'intention. Je ne cherche pas à savoir pourquoi tu as fait ça, je signifie mon agacement, sur l'interprétation de ton post.

par contre, l'impératif est une injonction, de plus sur un point que j'estime faux : prêter de mauvaise intentions, avec une fin de post en bref, pouvant être aisément interprété comme la manifestation d'une lassitude, permettant de couper court à une conversation désagréable.

Du coup, tu ne veux pas envenimer, tu ne tiens pas à débattre, ridiculise mon agacement (monter sur tes grands chevaux) mais tu formules des injonctions et coupes court à la discussion.

Dans l'absolue, je n'ai pas à t'expliquer comment avoir des échanges sains, mais en tout cas tes modalités pour échanger avec moi ne me conviennent pas du tout.

[^] # Re: Risque de déconvolution ?

Posté par AlexTérieur . Évalué à -4.

Alors si déjà vous vous trompez de personne…

A l'avenir il faudra prêter plus d'attention. Ou arrêter de faire des amalgames tout seul dans sa tête.

[^] # Re: Risque de déconvolution ?

Posté par freejeff . Évalué à 1.

Le message répondait principalement à ça :

Il est bien indenté par rapport au poste de barmic, même si j'inclue des éléments de vos postes, donc pas de problème d'amalgames tout seul dans ma tête. En général sur ce forum, lorsque l'on répond à quelqu'un l'indentation permet de comprendre qui est destinataire direct.

Enfin pour être plus clair :

Évoquer de manière péremptoire que l'on est en dehors des lois de la physique, est assez désagréable, lorsque l'on ne cherche pas à comprendre les enjeux et les possibilités qu'il existe en analyse d'images, et c'est d'ailleurs sur ce sujet que Francesco vous répondait.

Ce n'est pas un problème pour moi de se tromper, mais ayant un on égo de chercheur de la génération Y, les positions d'autorités me rendent souvent agressif, encore plus dans cette période de police de la pensée liée à la Covid19.

Désolé, de vous avoir vexé.

[^] # Re: Risque de déconvolution ?

Posté par AlexTérieur . Évalué à -5. Dernière modification le 23 septembre 2021 à 18:06.

Peut être, mais quand on est n'est pas capable de distinguer un filtre de flou d'un filtre de bougé… point. Final. A la ligne.

[^] # Re: Risque de déconvolution ?

Posté par freejeff . Évalué à 4.

Bon il y a du niveau …

Bon, photoshop, ce n'est pas la science hein, il va falloir réfléchir un peu avant d'écrire des sottises.

Vous ne comprenez visiblement rien au sujet, mais vous insistez pour avoir le dernier mot …

Non, ça mérite bien le fameux duty call

Tout les flous que je connais peuvent être vus comme un opération de convolution (peut être qu'il en existe qui échappent à cette affirmation) entre une image non-floutée et un noyau de convolution appelée fonction d'étalement du point ou PSF, comme expliqué précédemment. Donc, si on connaît la PSF, on peut déconvoluer.

Dans ce contexte, la distinction entre un flou isotrope tel que celui appliqué sur l'image se révèle être une PSF différente, point final. Créer une PSF revient à prendre une réponse impulsionnelle et appliquer le filtre, puis normaliser par la moyenne des niveaux de gris …

Ce n'est pas bien dur à faire. Ensuite, on passe dans un algo de type déconvolution de Wiener, on choisi l'amplitude du bruit qui imposera une coupure fréquentielle à l'image et c'est fini. On n'est pas dans les experts à Miami là tout de même …

Au passage un flou de bougé est infiniment plus difficile à reconstruire qu'un simple flou gaussien isotrope avec un gros écart type … Donc, si ça marche pour le flou de bougé, ne parlons pas du flou appliqué ici.

Un peu confus non ? C'est final genre -->[] ou c'est à la ligne …

[^] # Commentaire supprimé

Posté par Anonyme . Évalué à 4.

Ce commentaire a été supprimé par l’équipe de modération.

[^] # Re: Risque de déconvolution ?

Posté par tao popus . Évalué à 3.

Comme certains ont répondu plus haut, le carré noir.

# Cas où le floutage n'est pas appliqué

Posté par HL . Évalué à 3.

Je viens de le tester sur une vidéo personnelle, j'ai vu au moins les cas suivants où le filtre n'a pas été appliqué :

Ceci dit, je n'ai pas tous les modules dont dépend deface à jour, ça peut peut-être expliquer le comportement.

[^] # Re: Cas où le floutage n'est pas appliqué

Posté par Gil Cot ✔ (site web personnel, Mastodon) . Évalué à 3.

Le journal mentionne :

Dans ton cas, tu as joué avec quels paramètres ?

“It is seldom that liberty of any kind is lost all at once.” ― David Hume

[^] # Re: Cas où le floutage n'est pas appliqué

Posté par HL . Évalué à 1. Dernière modification le 23 septembre 2021 à 15:54.

C'était avec les paramètres par défaut (sur le coup, pas pensé à jouer avec le seuil). J'ai mis le seuil à

0.075, mes constatations à chaud sur des cas de non-floutages :Un chien¹ de profil et une ou plusieurs peluches ont été floutés. :D

Quelques faux positifs (du feuillage, des motifs de tissus, etc.).

Ceci dit, bravo aux concepteurs, c'est plutôt bon et très accessible.

¹ Ressemblant à un berger allemand.

[^] # Re: Cas où le floutage n'est pas appliqué

Posté par Gil Cot ✔ (site web personnel, Mastodon) . Évalué à 2.

Presque les mêmes cas donc. Faut comparer avec les images d'entrainement publiés sur le site pour voir ce qui a pu échapper à l'analyse.

Un œil : je me serais dit, normal il en faut deux pour un visage… Mais si on a un bandeau de pirate ? (catégorie des images avec déguisements ou maquillages) Mais qui des photos de profit ? (par contre la forme du visage n'est plus la même)

Visage vers le haut : en effet si on ne voit que le menton et le cou ça devient limite, mais si d'autres éléments permettent de dire algorithmiquement qu'on a un visage humain alors ça devrait pouvoir se corriger sinon on risque de cacher un peu n'importe quoi à la longue.

“It is seldom that liberty of any kind is lost all at once.” ― David Hume

# Package standalone Win32

Posté par Tarnyko (site web personnel) . Évalué à 3.

Réaction un peu tardive (le temps que je me rappelle de l'existence de l'outil, que je le teste…),

…mais un paquet Windows standalone est désormais disponible ici.

Suivre le flux des commentaires

Note : les commentaires appartiennent à celles et ceux qui les ont postés. Nous n’en sommes pas responsables.